Появление ChatGPT облегчило работу многим, включая, увы, мошенников и прочих злоумышленников. Например, доподлинно известно, что нейросеть используют для написания фишинговых писем и даже вредоносного кода приложений. И это несмотря на установленные разработчиком ChatGPT OpenAI этические ограничения. Уже существуют специальные чат-боты для хакеров, наподобие WormGPT. В связи с этим мир обеспокоился безопасностью — люди бояться, что ChatGPT и подобные нейросети совершат настоящий киберпереворот в виртуальном пространстве.

Начальный уровень угрозы

Канадская компания Flare обнаружила в даркнете свыше 200 000 доступов к ChatGPT. Специалисты отмечают, что всего за 6 месяцев в различных тематических группах и формах хакеров нейросеть упоминалась более 27 000 раз.

Сама по себе нейросеть не представляет угрозы, уверяют эксперты по кибербезопасности. Опасность ChatGPT представляет лишь опосредованную, ведь к ее «услугам» могут прибегнуть злоумышленники при составлении массовых атак. Нейросеть просто примет на себя нагрузку, которую раньше доверяли человеческому ресурсу.

Разумеется, ChatGPT может писать код, причем на уровне начинающего программиста. Благодаря этому злоумышленник может создать вредоносный код как на уровне сайта, так и на уровне программы. И ему вообще не потребуется познаний в программировании. Это не говорит о том, что хакеры и мошенники-копирайтеры останутся не у дел. Однако рутинные операции вполне реально делегировать ChatGPT. Это сократит и время, и трудозатраты, и нивелирует «человеческий фактор».

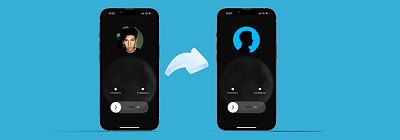

Чат-боты и прочие нейросети могут генерировать довольно правдоподобные дипфейки, которые впоследствии могут быть использованы для шантажа. Нейросетям доверяют даже имитацию голоса, например, при мошеннических звонках.

Мошенники научились выуживать данные как из самих чат-ботов (поэтому специалисты настоятельно не рекомендуют использовать сторонние интерфейсы и не делиться с ChatGPT-подобными нейросетями личными данными), так и опосредованно. Например, создаются мошеннические страницы с точками доступа к ChatGPT и подобными нейросетями. Пользователи вводят регистрационные данные, которые сразу попадают в руки мошенников.

Ленивый уровень угрозы

Языковые модели нейросетей активно используются злоумышленниками во всем мире. Даже в России аналитики «Лаборатории Касперского» выявили схему, которая позволяла мошенникам выманивать деньги через чат-бота. Приманкой был поиск интимных фото в Telegram. Естественно, никаких фотографий обманутым людям не присылали, схема была проста до безобразия (потому и работала):

- в описании указывалось, что бот работает на модели ChatGPT;

- в распоряжении нейросети есть слитая база переписок telegram;

- бот просил ссылку на профиль в соцсети (номер телефона) человека, интимные фотографии которого нужно отыскать;

- система просила 390 руб. за разовый поиск и 990 руб. за безлимит.

Переводимые деньги оседали в карманах злоумышленников, только и всего.

В русскоязычном сегменте пока не было данных о том, что нейросеть использовании для крупного мошенничества. А вот на Западе ChatGPT уже привлекают к написанию поддельных оповещений от соцсетей с предложением сменить пароль. Ссылка из письма ведет на фишинговую страницу.

В России же ChatGPT используют ленивые злоумышленники, которые просят бота написать письмо с определенным инфоповодом. По сути, языковую модель используют в роли копирайтера, преимуществом которого является минимум орфографических и грамматических ошибок. Считается, что если в письме много ошибок, то оно должно расцениваться как подозрительное.

Не менее любопытным является опыт использования ChatGPT на одном из русских хакерских форумов. Там нейросеть примерила роль секретаря и отвечает на новые сообщения в темах.

Этический уровень угрозы

Основная проблема любой нейросети, включая и ChatGPT — генерация контента только на основании уже созданного контента. То есть «машина» не придумывает ничего нового, а просто строит вариации ранее обслуженного. Поэтому хакерские атаки на данному уровне развития искусственного интеллекта вряд ли будут более сложными.

А вот повышение правдоподобности мошеннических писем стоит воспринимать как выросшую угрозу. Но, к счастью, пока не для России, а лишь для англоязычных стран. Да и в целом, ChatGPT лишь оптимизирует мошеннические и хакерские процессы, но никак не выполняет работы за людей.

Куда большей проблемой являются вариации ChatGPT без каких-либо ограничений. Именно эти языковые модели ответственны за генерацию вредоносного кода и проведение хакерских атак. Июльский WormGPT — яркое подтверждение того, что устранение этических ограничений языковой модели GPT-J 2021 года способно сделать нейросеть эффективным мошенническим инструментом. «Разработчик» неэтичной нейросети предлагает разрабатывать в WormGPT вредоносный софт высшего уровня. За доступ к сети просят 60 евро в месяц, а годовая подписка обойдется в 550 евро.

WormGPT — это тот же ChatGPT, но модель обучалась на специфическом контенте. Нейросети «скормили» множество видов нелегального контента, который помогает обманывать людей. При этом, у модели просто убрали этические ограничения. В результате основным назначением бота стали фишинговые рассылки и компрометация деловой переписки. Основное давление идет на психику с упором на эмоции. В этом помогает использование «болевых точек» адресата, наподобие новостного фона или финансовых проблем. Оформлены такие сообщения грамотно, четко, структурировано. Главное, чтобы у читателя подобного «творчества» не возникло ощущения подвоха.

Поскольку для WormGPT «родным» является английский язык, злоумышленникам из неанглоговорящих стран приходится прибегать к дополнительным уловкам:

- написание оригинала и задания для нейросети на «родном» языке;

- использование переводчика для постановки задачи;

- использование переводчика для перевода результата;

- редакция конечного текста в ChatGPT для устранения лексических и прочих ошибок.

Конечно, в России подобное почти не практикуется (сведений об этом, по крайней мере, нет). Основной задачей мошенников за рубежом является убеждение жертвы оплатить какую-либо сумму по подставному счету. В РФ подобной практики попросту нет, и любое предложение через письмо что-то оплатить у русскоязычного пользователя сразу вызывает подозрение. Но знать о таких атаках нужно всем, ведь подобная практика может возникнуть и в России. Защититься от нее можно лишь через тщательную проверку входящих данных.

Совершенный уровень угрозы

Возможных способов использования ChatGPT и подобных моделей — бессчётное множество. Удручает то, что сама нейросеть может подать идею. Вход в киберпреступность благодаря нейросетям облегчен максимально, и по сути, даже ребенок может придумать и поставить задачу нейросети, а потом воплотить ее по подсказкам.

Дополнительной проблемой является совершенствование ChatGPT, что приведет к взрыву мошенничества с использованием искусственного интеллекта. Необремененная этическими нормами нейросеть будет подделывать документы, создавать фейковые сайты, генерировать фото и играть большую роль в социальной инженерии.

Любая нейросеть — это способ автоматизации, который дает хакерам и прочим злоумышленникам огромные возможности, гораздо большие, чем кажется и используется сейчас. Фишинговые письма, простые вирусы и примитивные фейки — с этим можно жить и бороться. Но в скором будущем мир может столкнуться с массовыми эксплойтами под многоступенчатые атаки. Причем писаться такой код будет в течение считанных часов. И 2023 год является показательным, поскольку пессимистичные прогнозы указывают на кратное увеличение количества хакерских атак к его концу.

Оптимистические выводы

Впрочем, вряд ли ChatGPT и подобные нейросети смогут совершить настоящую киберреволюцию. Нейросети в текущей реализации являются всего лишь способом автоматизации рутинных процессов. Но это не тот случай, когда количество переходит в качество. Как и при любой «конвейерной сборке», процент брака значительно увеличивается в сравнении с ручными трудом. Поэтому все, что может современный искусственный интеллект в руках злоумышленников — экспоненциально увеличить количество атак, не более.

Еще одним сдерживающим фактором выступает совершенствование технологий защиты. Алгоритмы текстового анализа уже способны выявлять тексты, вышедшие «из-под пера» языковых моделей типа GPT. Да и общество все больше адаптируется к цифровизации, что снижает эффективность ранее работавших схем и сценариев.

Но рост новых атак будет. Будет расти и их качество, что, впрочем, наблюдалась с первых дней «массового» интернета.